文章

本文整理自阿里巴巴高级技术专家向邦宇在 QCon 的演讲,深入探讨了 Vibe Coding(氛围编程)在阿里内部的演进与挑战。文章首先将 Vibe Coding 工具归纳为 Native IDE、插件、Web Agent 和 CLI 四类,并指出 Agent 模式在提升高频开发者产出方面效果显著。随后,作者重点分析了当前 AI 编程面临的代码质量(自洽性错误、安全漏洞)、调试困难(黑盒化)、上下文局限及高昂成本等核心痛点。针对这些问题,阿里团队提出了构建 Repo Wiki、建立 Agent 数据协议、任务模板化以及“Agent 即工具”等架构优化方案。此外,文章还详细分享了如何通过工程化手段(如死循环检测、格式修复)将国外 SOTA 模型替换为国产开源模型,以实现效能与成本的平衡。

文章基于 Anthropic 发布的最新报告,系统梳理了 2026 年 Agent 编程的八大趋势。核心观点认为,AI Agent 已从实验工具进化为生产系统,软件开发生命周期(SDLC)正经历自 GUI 以来最大的变革。开发周期将从“周”压缩至“小时”,工程师角色从“编码者”转型为“指挥官”,专注于架构设计与任务编排。报告还探讨了多 Agent 协同、长时间自主运行、编程民主化以及安全双刃剑等前沿议题,强调人类的判断力和系统设计能力在 Agent 时代将变得更加稀缺和重要。

文章详细介绍了字节跳动最新发布的视频生成模型 Seedance 2.0。作者通过大量实测案例,展示了该模型在“导演思维”上的显著进步,即能够自动处理复杂的分镜、节奏和情感表达,而不再是简单的图生视频。文章重点分析了七大核心玩法:导演思维、分镜复刻、经典二创、编辑现实、素材生成 Vlog、带货广告以及极其震撼的主体动作迁移。作者作为 AI 影视从业者,在惊叹模型能力达到世界领先水平的同时,也表达了对传统 AI 影视工作流被瞬间颠覆的深度焦虑,认为 AIGC 已正式从“童年时代”跨入“青年时代”,呼吁从业者必须快速拥抱变革。

文章总结了 OpenClaw 创始人 Peter Steinberger 对 AI Agent 未来发展的深度思考。他认为 AI 革命的核心在于从“思考者”转向“行动者”,即 AI 需具备直接调用 API 执行任务的能力。Peter 极力主张“本地优先”架构,强调数据主权与隐私保护在 AI 时代的重要性。此外,他提出了激进的“App 消失论”,认为未来 80% 的应用将退化为纯粹的 API 接口,用户将通过统一的自然语言界面进行交互。在技术实现上,他推崇多模型协作的“群体智能”而非全能大模型,并认为 CLI 交互比模拟人类点击(MCP)更高效,长期记忆则是构建个性化 AI 助手的关键护城河。

文章详细介绍了 OpenAI 发布的编程 Agent 应用 Codex。作者认为 GPT-5.3-codex 在响应速度、额度和逻辑能力上表现出色,尤其适合非专业编程背景的用户进行 Vibe Coding(意图驱动编程)。内容涵盖了 Codex 的基本概念、Mac 客户端的安装流程、基于“文件夹-线程”的项目管理逻辑,以及定时任务、Skills 插件可视化管理、全局规则配置等核心功能。此外,作者还分享了实战技巧,如利用 Plan 模式进行需求规划,以及结合 Claude 优化前端界面的混合开发工作流,强调了 AI 如何铲平编程门槛,让创意得以快速实现。

本文记录了软件工程大师 Grady Booch 对 Anthropic CEO 关于“软件工程将死”言论的有力反击。Booch 认为,软件工程的核心在于复杂系统中的权衡与取舍,而非单纯的代码编写。他通过回顾软件工程与 AI 的三个黄金时代,阐明了技术演进始终伴随着抽象层级的提升。他预测未来代码将分化为“一次性自动化代码”与“长期存在的系统”,并建议开发者通过研习系统理论、生物学和神经科学,提升在规模化条件下管理复杂性的能力,从而在 AI 时代实现职业升维。

文章聚焦于 AI Agent 在处理长程任务时的不可靠性,深入解读了 Anthropic 的论文《The Hot Mess of AI》。通过引入统计学中的“偏差-方差分解”工具,研究发现 AI 的错误可分为“偏差”(笨)和“方差”(疯)。实验证明,随着推理链条增长,由方差导致的不连贯性直线上升;且大模型在难题上虽然偏差更低,但方差却更难压制。文章从数学角度指出,自回归模型本质上是动力系统,而 Agent 需要的是优化器,两者存在天然冲突。最后,作者探讨了集成学习、系统 2 思考及超越 Token 的新范式(如 LCM)等潜在的解决路径。

本文是快手技术团队对其三年 AI 研发范式演进的深度总结。文章指出,企业在引入 AI 时普遍面临“提效陷阱”:即个人编码效率的提升往往无法转化为组织整体交付能力的增长。为破解此难题,快手经历了从平台化、智能化 1.0(聚焦个人工具)到智能化 2.0(聚焦组织协同)的跃迁。核心举措包括:建立严格的 AI 代码生成率度量体系、构建支持 AI 上下文传递的智能工作流平台(Flow),以及定义从 L1 辅助到 L3 自主的研发成熟度模型。实践证明,只有将 AI 深度嵌入端到端的需求交付流程,并重塑人机协作模式,才能实现组织级的效能突破。

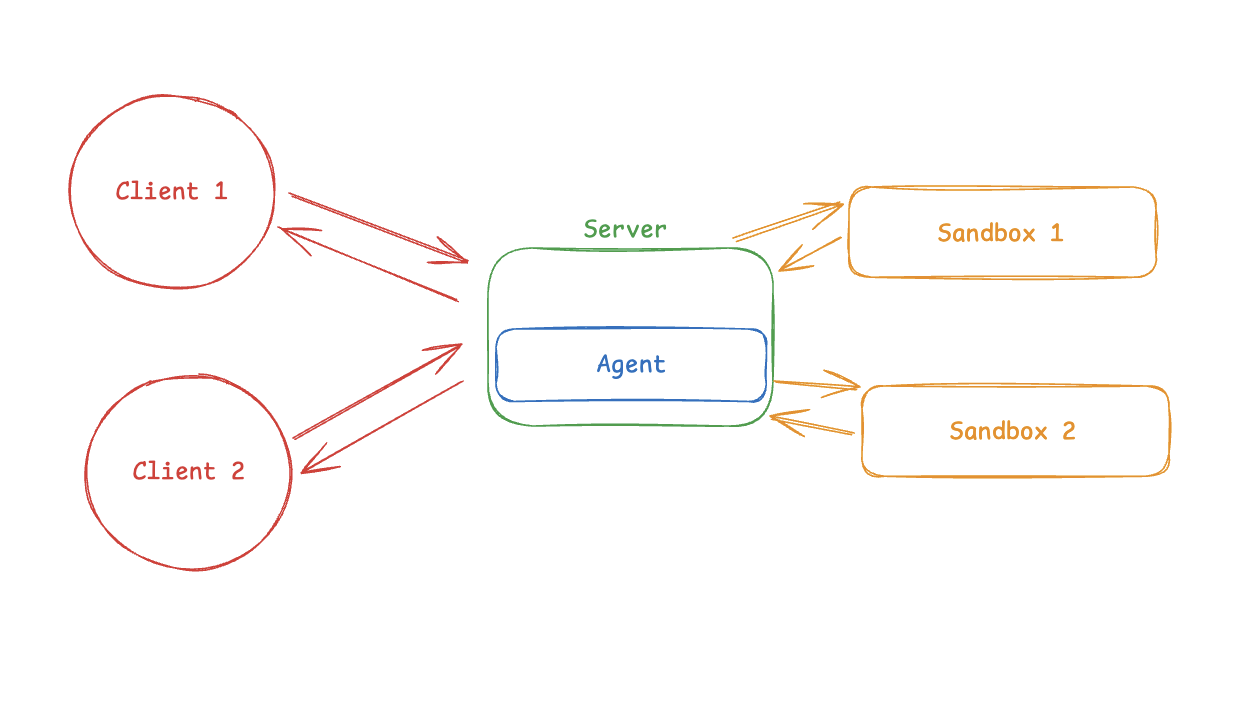

文章探讨了 AI 智能体需要隔离“工作区”(沙箱)以安全执行代码而不损害宿主系统的迫切需求。它正式提出了两种主要的集成模式:“智能体在沙箱内”和“沙箱作为工具”。在模式 1 中,智能体驻留在沙箱内部,提供类似于本地环境的开发体验,但会引入 API Key 泄露和知识产权外泄等风险。在模式 2 中,智能体在外部运行并通过 API 调用沙箱,这有助于更快的迭代、更好的凭据安全性以及推理与执行的清晰分离。文章最后给出了使用 deepagents 框架的实际实现示例,帮助开发者根据对耦合度、安全性和速度的具体需求选择合适的架构。

文章详细介绍了美团 LongCat 团队开源的 LongCat-Flash-Lite 模型。该模型采用“非典型 MoE”设计,将近一半参数(31.4B)分配给 N-gram 嵌入层,配合专用缓存、内核融合及推测解码技术,实现了以 3B 级激活参数达到 80B 级性能的效果。在推理效率上,其 API 可达 500-700 token/s。评测显示其在 Agent 工具调用和代码修复(SWE-Bench)等实战场景中显著领先同类模型。文章还提供了基于 Transformers 和 SGLang 的生产级部署指南及 Function Calling 实战示例,并宣布该模型采用 MIT 协议开源。